Чат-бот ChatGPT не смог решить школьную задачу

Школьная задачка поставила в тупик искусственный интеллект.

В последние несколько недель после того, как компания OpenAI презентовала новейшую версию популярного чат-бота ChatGPT, новости о его возможностях не сходят с первых страниц информационных сайтов и газетных полос. ChatGPT с легкостью проходит тесты, сдает экзамены и демонстрирует (по мнению некоторых) «производительность на уровне человека». Однако недавно нейросеть крупно опозорилась, сообщает Naked Science.

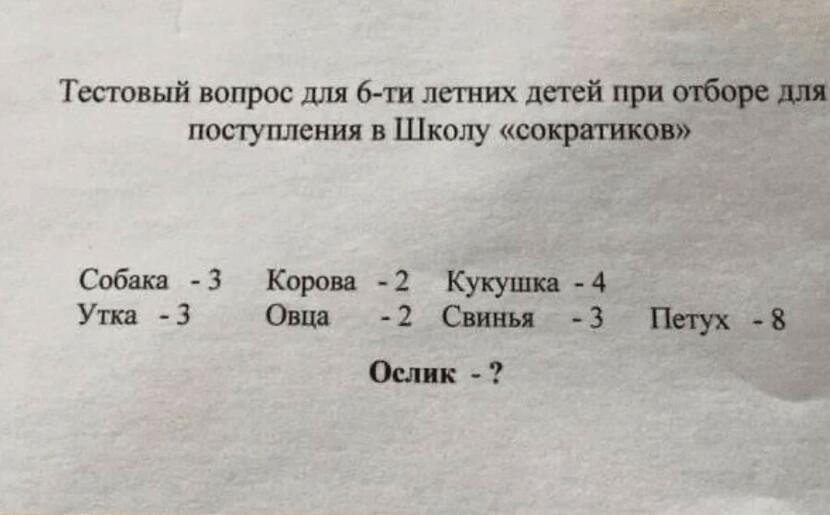

Недавно последней версии ChatGPT предложили решить математическую задачку для детей, которые пойдут в первый класс. Задача такая: «Собака — 3, петух — 8, лягушка — 3, корова — 2, ослик — ?». Чат-бот дал ответ, что в слове ослик пять букв. Однако после уточнения, что ответ неверный, программа заметила, что «из данного вопроса невозможно точно определить, о каком атрибуте животных идёт речь». ChatGPT заявил, что если, к примеру, речь идёт о количестве ног животного, то тогда ответ будет другим, но вообще необходима дополнительная информация.

Пользователи озадачили этим же запросом предыдущую версию: GPT-3.5. Она дала другой ответ, но тоже неправильный. Речь в задаче идёт о звуках, которые издают животные. Собачка лает и в слове «гав» 3 буквы. Овца блеет «бе» (2 буквы), и по аналогии с этим ослик говорит «иа». Значит, правильный ответ на эту задачу: два, так как именно столько букв в этом междометии.